英伟达发布Eagle2.5视觉语言模型 8B参数性能媲美GPT-4o

【太平洋科技快讯】近日,英伟达推出了一款名为Eagle 2.5的视觉-语言模型(VLM),专注于长上下文多模态学习,在处理大规模视频和图像方面表现出色。

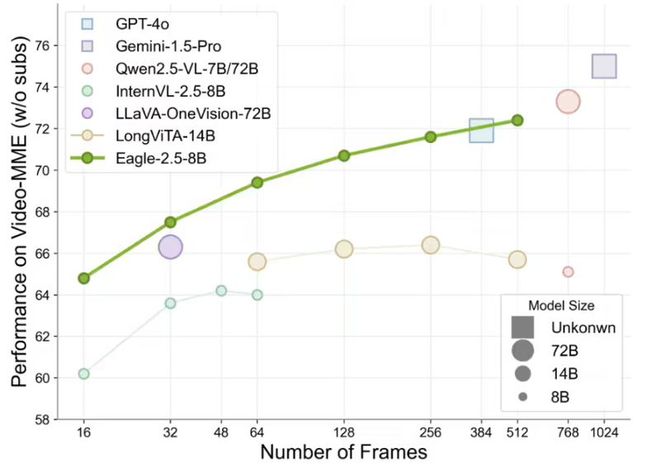

Eagle 2.5是一款专注于理解大规模视频和图像的视觉-语言模型,尤其擅长处理高分辨率图像和长视频序列。尽管其参数规模仅为8B,但在Video-MME基准测试(512帧输入)中,Eagle 2.5取得了72.4%的得分,这一成绩足以媲美Qwen2.5-VL-72B和InternVL2.5-78B等参数量更大的模型。

据悉,Eagle 2.5的成功离不开两项关键的创新训练策略:信息优先采样(Information-First Sampling)和渐进式后训练(Progressive Post-Training)。

信息优先采样策略通过两种技术手段来优化模型训练:

图像区域保留(IAP)技术: IAP技术能够保留超过60%的原始图像区域,有效减少宽高比失真,从而更好地保留图像的完整性。

自动降级采样(ADS): ADS技术则根据上下文长度动态平衡视觉和文本输入,在保证文本完整性的同时,优化视觉细节的呈现。

渐进式后训练策略则通过逐步扩展模型的上下文窗口,从32K到128K token,使模型能够适应不同长度的输入,并在各种情况下保持稳定的性能,避免对单一上下文范围的过拟合。

Eagle 2.5的训练数据管道整合了开源资源和定制数据集Eagle-Video-110K。该数据集专为理解长视频而设计,采用了独特的双重标注方式:自上而下的方法,采用故事级分割,结合人类标注的章节元数据和GPT-4生成的密集描述,提供宏观的叙事结构;自下而上的方法,利用GPT-4o为短片段生成问答对,捕捉时空细节,提供微观的信息补充。

此外,通过余弦相似度(cosine similarity)筛选,数据集强调多样性而非冗余,确保叙事连贯性和细粒度标注,显著提升了模型在高帧数(128帧)任务中的表现。